Markovketen

Een Markovketen, genoemd naar de Russische wiskundige Andrej Markov, beschrijft een systeem dat zich door een aantal toestanden beweegt en stapsgewijs overgangen vertoont van de ene naar de andere (of dezelfde) toestand. De specifieke Markov-eigenschap houdt daarbij in dat populair uitgedrukt: "de toekomst gegeven het heden niet afhangt van het verleden". Dat betekent dat als het systeem zich in een bepaalde toestand bevindt, het toekomstige gedrag van het systeem, dus de komende overgangen, slechts afhangen van de huidige toestand en niet van de weg waarlangs deze toestand tot stand is gekomen. De successievelijke toestanden van het systeem worden beschreven door een rij stochastische variabelen , waarin de verwachte toestand van het systeem is na stappen. De Markov-eigenschap wordt uitgedrukt in een eigenschap van de overgangskansen.

Definitie

Een Markovketen van een systeem met mogelijke toestanden , beschrijft de mogelijke evolutie van het systeem door de tijd, op regelmatige tijdstippen , door middel van een reeks van stochastische variabelen over die berekend worden met:

en de begintoestand van het systeem. Het is een vector met elementen, namelijk een waarschijnlijkheidsverdeling over . Als de begintoestand is vastgelegd, bijvoorbeeld toestand 1, is het eerste element van deze vector 1 en de andere elementen 0. Algemeen geldt dat de elementen van de vector liggen tussen 0 en 1 en dat hun som gelijk is aan 1.

De -matrix is de (eenstaps)overgangsmatrix. Het getal is de kans dat het systeem overgaat van toestand naar toestand . Anders gezegd: dit is de voorwaardelijke kans dat het systeem op zeker tijdstip zich bevindt in toestand , gegeven dat het systeem zich op tijdstip in toestand bevond. Hiervoor geldt de Markov-eigenschap, die zegt dat deze waarschijnlijkheid alleen afhangt van de toestand op tijdstip en niet van de daaraan voorafgaande toestanden:

- .

Het systeem heeft met andere woorden geen "geheugen". Men noemt dit een Markovketen van de eerste orde in discrete tijd: het systeem kan enkel van toestand veranderen op regelmatige tijdstippen.

Generalisaties

De definitie van Markovketen kan op verschillende manieren gegeneraliseerd worden:

- Het systeem kan een oneindig aantal discrete toestanden aannemen of een continue toestandsruimte bezitten, zoals bij de brownse beweging. Als de toestandsruimte continu is, spreekt men van een Markovproces en niet van een Markovketen; maar de termen worden vaak door elkaar gebruikt.

- De eenstapsovergangskansen kunnen afhankelijk zijn van het tijdstip . Als de overgangskansen niet variëren in de tijd noemt men de Markovketen homogeen;

- Men kan een Markovketen van orde beschouwen waarvan de eenstapsovergangskansen niet slechts afhangen van de vorige toestand, maar van vorige toestanden ():

- In plaats van een systeem dat enkel op regelmatige, discrete tijdstippen verandert kan men ook een systeem beschouwen in continue tijd, dat op onregelmatige tijdstippen van toestand verandert.

Voorbeelden

Voorbeeld 1

Een muis beweegt zich door een huis met op de bovenverdieping de vertrekken 1, ..., 5 en op de benedenverdieping de vertrekken 6, 7 en 8. Hij kan zich vrij op de bovenverdieping door de vertrekken bewegen, maar mocht hij in de slaapkamer 5 door het gat in de vloer vallen, dan is er geen weg terug en is hij gedwongen beneden te blijven. In de keuken (8) staat een val, waar de muis, mocht hij zich in de keuken wagen, beslist in terechtkomt. Op zoek naar eten loopt de muis rond en weet zich echt niet te herinneren of hij al in een vertrek geweest is. Hij kiest daarom met gelijke kansen naar een van de aangrenzende vertrekken te gaan.

Het systeem laat zich mooi beschrijven met een gewogen, gerichte graaf:

Een typisch verloop kan zijn dat de muis zich aanvankelijk in vertrek 5 bevindt. Van daaruit kan hij, met voor elk kans 1/4, naar een van de vertrekken 2, 3, 4 en 7. Het leven van de muis, dat we een realisatie van het proces noemen, kan er schematisch zo uitzien: 5 4 1 4 1 2 5 7 6 7 8(bam!). Met meer geluk zou het kunnen zijn: 5 4 1 2 5 4 1 2 3 2 1 4 1 4 1 4 1 4 1 2 3 5 7 6 7 6 7 6 7 8, een aanmerkelijk langer leven.

Voor de bovenstaande graaf is dit de overgangs- of transitiematrix:

Zoals hierboven gezegd is in het getal op rij i en kolom j de waarschijnlijkheid dat het systeem van toestand i naar toestand j overgaat; hier dus de waarschijnlijkheid dat de muis van kamer i naar kamer j gaat. Dit zijn de getallen bij de pijlen in de bovenstaande graaf. is een stochastische matrix; elke rij van de matrix bestaat uit getallen tussen 0 en 1 en de som van elke rij is gelijk aan 1.

Aan de hand van deze matrix kan men de waarschijnlijkheid berekenen dat de muis vanuit kamer 5 precies het pad 5 4 1 4 1 2 5 7 6 7 8 volgt; het is de combinatie van de overgangswaarschijnlijkheden 5-4, 4-1, 1-4, 4-1 enz. Omwille van de Markov-eigenschap, is deze combinatie gewoon het product van deze overgangswaarschijnlijkheden:

De verwachte toestand van het systeem op tijdstip n wordt beschreven door een rijvector . Het aantal elementen van deze vector is gelijk aan het aantal mogelijke toestanden van het systeem (het aantal kamers in het huis in dit voorbeeld) en het i-de element in de vector is de waarschijnlijkheid dat het systeem zich in toestand i bevindt op tijdstip n; dus de waarschijnlijkheid dat de muis in kamer i is na n tijdstippen.

Stel dat de muis bij tijdstip 0 in kamer 5 verblijft, dan is de beginverdeling

- .

Vanuit kamer 5 kan de muis gaan naar kamer 2, 3, 4 of 7; de kans voor elke overgang is gelijk aan 1/4. Dit betekent dat we op tijdstip 1 de muis met een waarschijnlijkheid gelijk aan 1/4 kunnen aantreffen in kamer 2, 3, 4 en 7 en met waarschijnlijkheid 0 in de andere kamers. Dus

- .

Deze verdeling bekomen we door het matrixproduct te maken van de rijvector met de stochastische matrix P.

De waarschijnlijkheidsverdeling op tijdstip 2 vinden we op dezelfde manier

- .

In het algemeen geldt

Na honderd stappen is de toestandsvector geëvolueerd tot

- .

We zien dat, hoe verder we in de tijd vooruit kijken, hoe waarschijnlijker het wordt dat de muis in kamer 8 terechtkomt, vanwaar er geen uitweg is (dit volgt uit de 1 in de hoofddiagonaal van de stochastische matrix P). De toestandsvector is in de limiet, voor stijgende n, invariant (er geldt

- ) en gelijk aan ,

wat we kunnen uitdrukken als: het staat vast dat de muis ooit in kamer 8 terechtkomt. Deze asymptotische verdeling is onafhankelijk van de begintoestand : waar de muis zich ook bevond bij de aanvang, ooit zal ze in toestand/kamer 8 terechtkomen en er blijven. De toestanden/kamers 1 tot en met 7 hebben een limietwaarschijnlijkheid gelijk aan 0, wat betekent dat ze nooit meer zullen bezet worden na een voldoend lange tijd. Dergelijke toestanden noemt men overgangstoestanden (transient states); een toestand zoals toestand 8 in het voorbeeld is een absorberende toestand (absorbing state of trapping state).

Een Markovketen met de eigenschap, dat de waarschijnlijkheidsverdeling in de limiet onafhankelijk is van de begintoestand, noemt men compleet ergodisch.

Stel nu dat er in een ander huis twee muizenvallen zijn, bijvoorbeeld in kamers 4 en 8. De transitiematrix zal er dan anders uitzien dan hierboven, en tweemaal een 1 hebben op de hoofddiagonaal, in rijen 4 en 8. In dat geval is de Markovketen niet meer compleet ergodisch. In sommige gevallen zal de muis in de val lopen in kamer 4 en in sommige gevallen in kamer 8. De limiet-verdeling is hier dus niet meer onafhankelijk van de begintoestand.

De limietvector is een eigenvector van de overgangsmatrix, overeenkomend met de eigenwaarde 1. De stelling van Perron-Frobenius zegt dat elke stochastische matrix minstens één zo'n vector heeft (er kunnen er meerdere zijn, zoals in het geval van een Markovketen met meerdere absorberende toestanden) en dat 1 de grootste eigenwaarde is van de matrix. De voorwaarde is dat de matrix of de corresponderende Markovketen, irreducibel is. Daarvoor moet elke toestand van het systeem bereikbaar zijn vanuit elke andere toestand (er mogen geen delen van de graaf geïsoleerd zijn van andere delen).

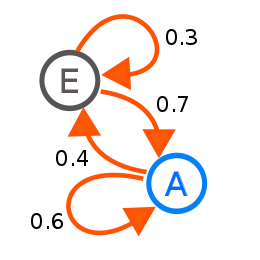

Voorbeeld 2

De hiernaast afgebeelde graaf stelt een Markovketen voor met twee toestanden, A en E. Als het systeem zich op een bepaald tijdstip in toestand A bevindt, is de waarschijnlijkheid dat het zich op het volgende tijdstip nog steeds in toestand A bevindt, gelijk aan 0,6; de waarschijnlijkheid dat het overgaat naar toestand E is gelijk aan 0,4. Als het systeem zich in toestand E bevindt, is de waarschijnlijkheid dat het overgaat naar toestand A groter: 0,7. De stochastische matrix voor dit systeem met toestanden A,E is:

- .

Stel dat het systeem vertrekt vanuit toestand A; dan is . In de volgende stappen vinden we voor de toestandsvector:

- , enz.

Als het systeem vertrekt vanuit toestand E, is . Nu vinden we in de volgende stappen:

- , enz.

Klaarblijkelijk evolueert , voor stijgende n, hier ook naar een constante vector die onafhankelijk is van de begintoestand van het systeem. Wat is die vector, ? Om die te vinden moeten we de vergelijking oplossen. Samen met de eis dat de som van de elementen van gelijk is aan 1, vormt dit een stelsel van lineaire vergelijkingen. Stel

- ,

dan is dat een stelsel van drie vergelijkingen in twee onbekenden:

(Een van de drie vergelijkingen is lineair afhankelijk van de andere twee). Door bijvoorbeeld te vervangen door in de eerste vergelijking, vinden we dat en dus is

- en .

Op lange termijn is de waarschijnlijkheid het grootst (namelijk 7/11) dat we het systeem aantreffen in toestand A. We hebben hier dus ook te maken met een compleet ergodisch proces, maar dan een zonder overgangstoestanden. De toestanden A en E zijn recurrente toestanden, die met zekerheid een oneindig aantal malen zullen voorkomen als n naar oneindig gaat. Een Markovketen zoals deze, waarin elke toestand recurrent is, noemt men een recurrente keten.

We kunnen hier ook de waarschijnlijkheid berekenen dat het systeem zich in een toestand i bevindt en exact n tijdstippen in dezelfde toestand blijft; dus dat het de volgorde {i, i, ... , i, j} doorloopt waarin er n−1 maal een "overgang" van i naar i gebeurt gevolgd door een overgang van i naar j, waarin j verschilt van i. Die waarschijnlijkheid is:

De waarschijnlijkheid dat het systeem zich in toestand A bevindt en daar gedurende vijf opeenvolgende tijdstippen blijft en dan naar toestand E overgaat is dus gelijk aan 0,64.(1−0,6) = 0,05184.

Het verwachte aantal opeenvolgende gelijke toestanden, dus de verwachte duur dat het systeem in eenzelfde toestand blijft, is dan gelijk aan:

In dit geval is dit voor toestand A : 1/(1−0,6) = 2,5 en voor toestand E: 1/(1−0,3) = 1,4286. Over een (oneindig) lange periode verwachten we dat het systeem gemiddeld 2,5 tijdsperioden in toestand A blijft en 1,4286 tijdsperioden in toestand E.

Voorbeeld 3: toevalsbeweging

Een toevalsbeweging ("random walk") in een netwerk of een rooster is een typische Markovketen. Stel dat het netwerk een binaire boom is zoals hiernaast afgebeeld, waarin een vlo voortdurend verspringt van een knooppunt naar een willekeurig aangrenzend knooppunt; zowel omhoog als omlaag (met de richting van de pijlen houden we geen rekening). De transitiematrix voor dit systeem met negen mogelijke toestanden, is:

De limietvector voor dit systeem laat zich eenvoudig berekenen; het is

- .

Deze waarden zijn evenredig met het aantal verbindingen van en naar de knooppunten in de boom.

Maar als we de waarschijnlijkheidsvector (n=0,1,2,...) berekenen voor het geval de vlo start vanuit knooppunt 1, vinden we dat die na verloop van tijd niet naar die waarde gaat maar blijft oscilleren tussen de twee waarden:

- in de even stappen, en

- in de oneven stappen.

Als de vlo vertrekt vanuit knooppunt 2 of 3 is de volgorde van deze twee vectoren omgekeerd. Dit is uiteraard het gevolg van het feit dat de vlo op elk tijdstip van niveau verandert in de boom. Als ze op tijdstip 0 op een "even" niveau begint zal ze op elk volgend even tijdstip ook op een even niveau zijn, en is de waarschijnlijkheid dat ze zich op een knooppunt van een oneven niveau bevindt noodzakelijkerwijs nul. De limietvector die hierboven berekend is, kunnen we beschouwen als de waarschijnlijkheid dat de vlo zich op een bepaald knooppunt bevindt op een willekeurig tijdstip in de toekomst.

Als we toelaten dat de vlo mag "rusten" op sommige punten, valt deze oscillatie weg en zal de toestandsvector evolueren naar een vaste limietwaarde. Na een groot aantal sprongen kan de vlo dan immers op elk knooppunt van de boom zitten. In dat geval zullen sommige waarden op de hoofddiagonaal van de overgangsmatrix verschillend van nul zijn.

Toepassingen

Markovketens en Markovprocessen worden in velerlei domeinen gebruikt voor het simuleren en analyseren van (computer)modellen van systemen waarvan de toestand geheel of gedeeltelijk van het toeval afhangt. Afhankelijk van de aard van het probleem wordt daarbij het transiënt gedrag van de keten dan wel de limiettoestand onderzocht.

- In de chemie kan het klassieke model van de kinetiek van enzym-gekatalyseerde reacties, beschreven door de Michaelis-Menten-vergelijking, voorgesteld worden als een Markovketen. Ook de groei en samenstelling van copolymeerketens kan met Markovketens geanalayseerd worden.

- In de wachtrijtheorie kan men Markovketens inzetten voor het analyseren van wachtrijproblemen en het optimaliseren van telecommunicatienetwerken.

- In de economische en financiële wereld komen Markovketens veelvuldig voor bij het modelleren van allerlei fenomenen, zoals bij Leontiefs input-outputanalyse. Het economische aspect komt bijvoorbeeld aan bod als aan een overgang van het systeem een bepaalde opbrengst (positief of negatief, winst of verlies) verbonden is. Men kan dan bepalen wat de verwachte opbrengst is in de volgende n stappen, in functie van de huidige toestand van het systeem (transiënt gedrag), of wat de verwachte opbrengst per stap is op lange termijn.

- De statistiek combineert Markovketens met Monte-Carlosimulaties in de zogenaamde MCMC-methode (Markov Chain Monte Carlo). Hierbij onderzoekt men steekproefsgewijs hoeveel stappen er nodig zijn om een vooraf bepaalde, stationaire verdeling van een Markovketen te bereiken of te benaderen binnen een bepaalde foutenmarge. De methode wordt o.m. toegepast om meerdimensionale integralen numeriek te berekenen.

- In kwaliteitsmanagement voor het bepalen van de betrouwbaarheid en beschikbaarheid van systemen, bijvoorbeeld van procescontrole- of regelsystemen.

- Veel spellen waarin het toeval een rol speelt kunnen als een Markovketen gemodelleerd worden.

- In de muziek kunnen Markovketens dienen als basis voor stochastische muziek, zoals bij Iannis Xenakis.

- Bij het berekenen van kans op wolkenvorming worden Markovketens toegepast, zie promotie-onderzoek van Jesse Dorrestijn van het Centrum Wiskunde & Informatica (CWI).